前几天,我妈给我发微信,“儿子,我出门忘

AI应用的爆发式增长,不仅带动算力需求飙升,也让其背后的巨大能耗问题日益凸显,成为行业发展的迫切痛点。近日,美国最大电网运营商PJM发布预警,数据中心的快速扩张正持续推高电力消耗,未来十年电网或将面临高达60吉瓦的电力缺口,这一数值相当于60座大型核反应堆的总发电能力,凸显出AI产业发展与电力供应之间的突出矛盾。

能耗压力下,AI数据中心的建设逻辑已从此前的“算力竞赛”加速转向“效能比拼”,各大科技巨头纷纷布局技术优化,通过自研AI加速器、推广数据中心液冷技术、协同可再生能源供电等多种方式,全力提升算力使用效率,破解能耗困局。其中,内存系统的优化被业界普遍视为缓解能耗压力的关键路径,原本应用于移动终端的低功耗内存(LPDDR),正逐步走进AI数据中心,成为巨头们提升系统能效的核心抓手。

此前,LPDDR内存主要应用于智能手机、智能手表等对续航高度敏感的移动设备,凭借低功耗优势适配移动场景的核心需求。而随着AI数据中心能耗压力的加剧,这种低功耗特性被科技巨头发掘,逐步应用于AI计算领域,成为破解能耗难题的重要突破口。目前,多家科技巨头已率先布局,将LPDDR内存融入自身AI基础设施建设。

微软近期正式推出面向数据中心的LPDDR5X内存系统解决方案,依托该产品高带宽、低功耗的核心特性,为云端AI推理及部分训练负载提供支撑,进一步优化数据中心的整体能效表现。Meta则在其自研的第二代AI运算芯片MTIA V2中,明确配置了LPDDR5/5X内存,目前该芯片已成功部署于其数据中心,有效降低了单位计算能耗,实现了效能提升。

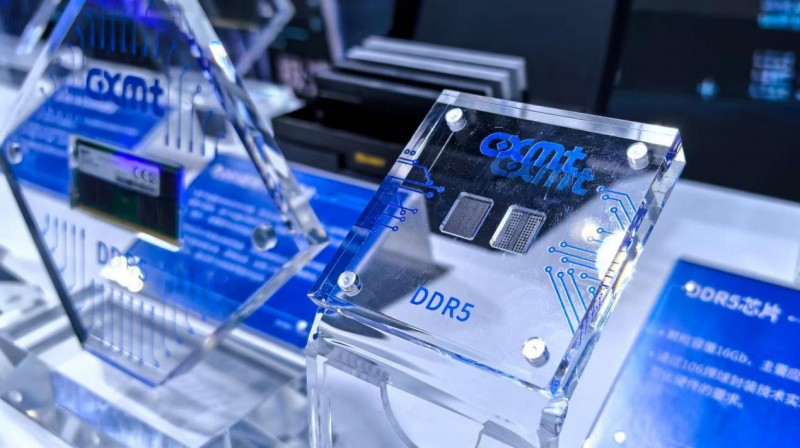

某科技公司资深战略总监解读称,为适配AI数据中心的高强度需求,科技企业正着力构建一套平衡性能、功耗与成本的完整内存与存储层级架构。这套架构融合了端侧计算与大规模云计算的分布式模式,可针对各类AI工作负载提供高效解决方案,高密度DDR5模块与LPDDR5X均是其中的关键组成部分,且形成了清晰的战略分工。

具体而言,DDR5承担着“核心容量池”的角色,其在性能、容量与成本之间的出色平衡,使其仍是承载海量模型参数的主流选择,能够为大规模并发推理提供稳定的带宽支撑。以国内厂商长鑫存储为例,其推出的DDR5产品最高速率达8000Mbps,较行业主流的6400Mbps提升25%,有效缓解了AI计算中的数据瓶颈。

LPDDR5X则定位为“能效破局者”,依托天生的低电压特性,在能效方面具备不可替代的优势。据测算,在百万台服务器规模的部署中,仅采用LPDDR5X一项,每年即可实现数亿美元的电费节约。长鑫存储的LPDDR5X产品表现尤为突出,最高速率可达10667Mbps,功耗较上一代降低30%,实现了高能效与高性能的双重提升。

该战略总监进一步补充,LPDDR能够突破移动设备领域,进军AI数据中心,不仅得益于其出色的能效表现,更离不开其背后成熟庞大的商业生态。每年数十亿颗智能手机的出货量,让LPDDR产业链形成了显著的规模效应,具备突出的“每GB成本”优势。对于规模化AI服务而言,“每笔推理成本”与“每焦耳带宽”是核心竞争力,LPDDR的成本优势恰好契合这一需求。

此外,LPDDR5X的高带宽与低延迟特性,精准匹配了AI推理任务(如内容推荐、自动驾驶)突发且多变的算力需求,能够稳定支撑7×24小时不间断运行的严苛场景。业内人士表示,随着AI模型规模与复杂度的指数级增长,单纯依靠增加算力的边际效益持续下滑,能耗攀升、成本压力及运维复杂度已成为行业必须应对的挑战。

当前,科技巨头在规划新一代数据中心时,已彻底转变思路,从过去“追求绝对算力”转向“为场景寻找最优技术组合”。低功耗内存跳出传统移动端、跻身AI数据中心核心应用,正是这一转变的生动体现,也标志着以GPU为代表的计算核心、以内存为代表的存储方案的协同优化,正深刻重塑AI算力的发展形态。

前几天,我妈给我发微信,“儿子,我出门忘

2026年2月10日晚,在巴塞罗那地标建

春节假期开启倒计时,想要出境游的你,心是

为深入贯彻落实全民健身国家战略,积极响应

在听力健康需求日益升级的当下,助听器市场

新春伊始,万象更新。2026年1月30日

当气势磅礴的英歌舞又双叒叕“火出圈”,是

腊月的机场大厅,攒动的人头折射出久违的出

新春将至,全网都在“卷”马年开运装备,从